什么是DPT?

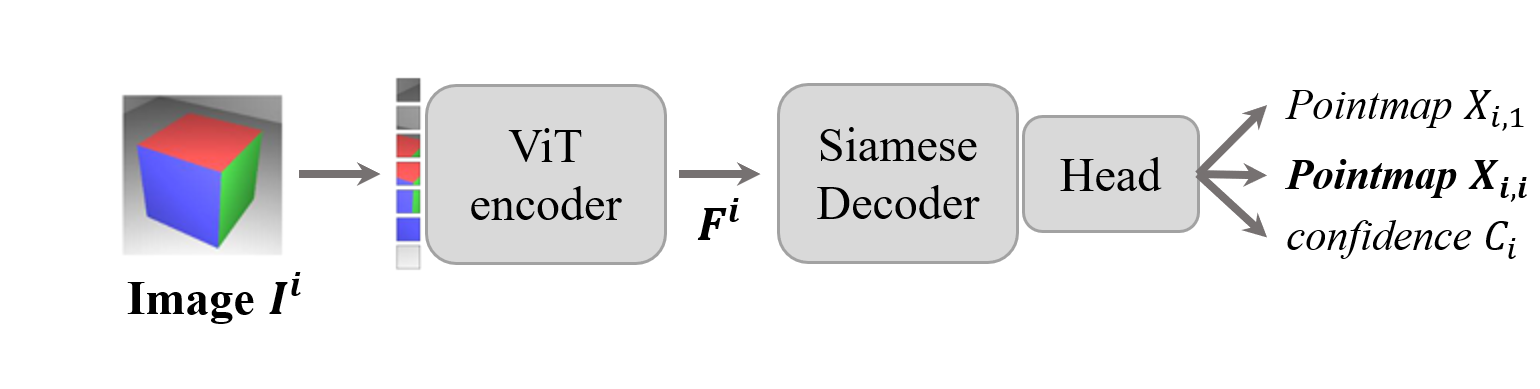

DUSt3R, MASt3R等预训练模型名字中总是包含dpt, dpt是什么? DUSt3R_ViTLarge_BaseDecoder_512_dpt.pth ## head一般是网络的最后一层或几层,用于将backbone提取的特征转为特定任务的输出。 dust3r中,有两种head类型, 分别是pts3d和dpt。 Vision transformers for dense ...

DUSt3R, MASt3R等预训练模型名字中总是包含dpt, dpt是什么? DUSt3R_ViTLarge_BaseDecoder_512_dpt.pth ## head一般是网络的最后一层或几层,用于将backbone提取的特征转为特定任务的输出。 dust3r中,有两种head类型, 分别是pts3d和dpt。 Vision transformers for dense ...

离散数学回旋镖系列 :) 想到一个问题: 假设有n个数字,有一个函数能够每次取一个数(概率相同),取完之后对应的标签位置为1,(可能取到位置为1的数,如果取到,则重新取),取完$n$个不同的数字最终的时间复杂度是多少 优惠券收集问题 概念: 期望 = 事件 * 事件发生的概率 在优惠券收集问题中,设总共有$n$种不同的优惠券,每次收集时得到一种新的优惠券的概率取决于已经收集到的优惠券...

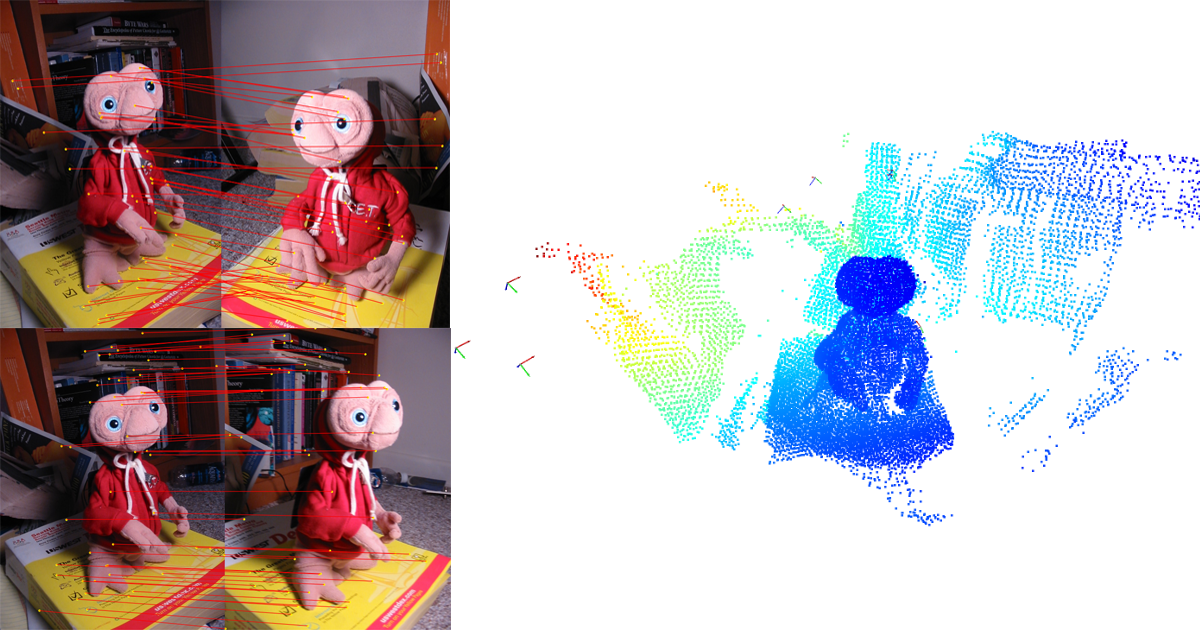

关于mast3r, dust3r, global alignment的一些理解 最近在kaggle上使用mast3r作为baseline, 遇到了一些disk溢出的问题 在sparse_global_alignment阶段, 会将所有的图像和图像对输入到forward_mast3r,计算对应关系,并将计算的结果缓存到cache目录下,之后的prepare_canonical_data阶段...

方法名称 核心策略 是否支持增量 效率表现 精度 & 全局一致性 发布时间 DUSt3R 两视图Transformer回归局部点云,需后续全局优化对齐 否 O(n²) 成对重建,效率低 精度高但误差累积,全局一致性依赖后处理优化 ...

第一次打kaggle比赛因为没什么经验,中间浪费了很多时间和提交次数来了解数据、测试流程和模型部署。 虽然没拿到牌子, 还是学到了不少东西。下次继续努力 :) 结束第一天总结 相比于自己搭建框架, 优先去复刻往年金牌的思路,注意其中提到的技巧以及baseline(其实写论文也是如此,站在巨人的肩膀上,不要因为非我发明综合征而去重复造轮子) 本地s...

关于robotiq 2F-85的ROS/ROS2驱动相关: 官方论坛的讨论 官方停止维护的github repo panagelak个人开发的ROS2 driver

来自croco的Transformer Block, 类似于ViT或Swin Transformer的基本块。 class Block(nn.Module): def __init__(self, dim, num_heads, mlp_ratio=4., qkv_bias=False, drop=0., attn_drop=0., drop_p...

并不是为了学习VAE 而是之前看LRM的openreview意见时,有个review提到,LRM是一个判别模型而非生成模型。那么什么是判别模型(discriminative)什么又是生成模型(generative) 今天在ai summer里偶然看到了对比,临时记录下 图来自:https://theaisummer.com/latent-variable-models/

本文是对diffusion的入门级学习记录。 现在只考虑最简单的情况 学习资料来自: How diffusion models work: the math from scratch apxml GaussianObject: High-Quality 3D Object Reconstruction from Four Views with Gaussian Splatting ...

手撕MHA 我们需要什么 首先, 点积注意力(Scaled Dot-Product Attention)是注意力机制所需的最小单元,你也可以叫他(自注意力) 准备QKV 首先我们需要将输入的tensor映射到Query, Key和Value三个向量空间中去。 self.W_q = nn.Linear(embed_dim, embed_dim) self.W_k = nn.Linea...